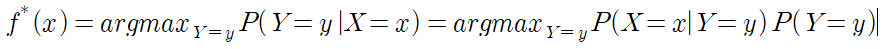

Optimal Classifier Learning에서, x에 대한 확률은 다음과 같다.

여기서 P(Y=y)는 클래스 개수 k에 대하여 k-1개의 parameter만 있으면된다.

문제는 P(X=x|Y=y) for all x,y에서 parameter의 개수는 개별 input feature 마다 2개의 case가 있다면 그 개수는 (2^d-1)k이다. k를 곱하는 이유는 2^d-1에서, T or F라면 True인 case, False인 case가 필요하므로 k만큼 곱해야 한다. (d는 the source of demand)

>> 문제가 된다.

conditional independence assumption:

개별 input feature를 독립으로 보자.

conditional indepence하다의 정의:

이 식을 잘 정리하면 다음과 같은 식이되는데, 이는 우리가 아는 독립에 대한 정의와 같다.

Conditional vs Marginal Independence:

루트 노드 1과 자식 노드 2,3인 이진 트리가 있다고 가정하자.

1이 2,3에게 어떠한 명령을 내렸을 때, 2,3은 1이 말하는 것을 듣지 못했다.(2,3은 1을 관측할 수 없다.)

이 때, 3이 명령을 수행할 때 2는 "1이 3에게 명령을 주었으니까 나도 수행해야지." 라고 생각할 수 있다.

>> 이는 2와 3이 독립적이지 않음을 의미한다.

marginally independent:

서로가 서로에게 아무런 영향을 주지 않을 때(위의 예시에 해당x)

conditionally independent:

서로가 서로에게 정의될 수 있다.(위의 예시에 해당)